Dostałeś informację w panelu Google Webmaster Tools o nienaturalnym linkowaniu i teraz chcesz zrobić z tym porządek ? Super ? ale wiedz, że nie ma jednej drogi, nie ma przepisu na to, aby odzyskać serwis po ukaraniu go za nienaturlane linki przychodzące – no i droga jest raczej dalsza niż bliższa.

1. Od czego zacząć ?

Przede wszystkim od zebrania jak największej ilości danych:

- co robiłeś, gdzie zostawiałeś linki, gdzie je inni zostawiali ?

- przydadzą się wszelkie raporty czy to z programów czy też ręcznego dodawania

- wreszcie trzeba skontaktować się z osobami/firmami, którym zlecało się to i owo aby takowe raporty dostarczyli

- NAJWAŻNIEJSZE !!! z panelu Google Webmaster Tools pobrać wszystkie linki/domeny jakie tam się znajdują – według Googlersów jest to podstawowa baza, na której należy pracować przy analizie

Jeśli nie masz raportów: nie płacz (będzie bolało) ale też można sobie poradzić.

2. Co zrobić z raportami – wstęp do analizy nienaturalnych linków przychodzących

Jeśli pozbierałeś już wszystkie raporty to teraz trzeba przystąpić do działania:

przeglądasz wszystkie linki pod kątem różnego rodzaju skryptów i możesz je podzielić oczywiście na katalogi i precle – to podstawowy podział – chyba obecnie wystarczający. Do tego oczywiście dochodzą fora (najczęściej te zagraniczne), blogi (też zagraniczne). Należy zwrócić też uwagę na nazwę domeny (np abyyyxyz.pl) oraz na fakt, czy serwis jest postawiony na poddomenie przykładowo sub2.sub1.sub0.domena.pl.

Kryterium jakie można tez zastosować to sprawdzenie PageRanku danej domeny głównej – i podzielić na N/A oraz 0 i wyższe. Te o niskim PR w większej części są podejrzane (ale uwaga: nie zawsze).

Do analizy wykorzystujemy … najczęściej excela, głowę i … własne wyobraźnię. NIE MA JEDNOZNACZNEJ odpowiedzi, który link jest zły a który nie. NIE MA !!! – jest to tylko Nasz własna subiektywna ocena wynikająca z różnych przesłanek.

Analiza jest długa, mozolna i zajmuje kilka dni. Jeśli nie wiesz jak – jesteś zmuszony poszukać kogoś, kto to za Ciebie zrobi.

3. Analiza

Jak już wspomniałem NIE MA jednoznacznego wskazania, który link jest zły a który nie. Pozycjonerzy bazują na swoim, jakże różnym wyobrażeniu – bo działamy na wyszukiwarce, która jest prywatnym zamkniętym rynkiem i którego algorytmu nikt nie zna. Dlatego też analiza nastręczać może dużo trudności. I zapewne jest źródłem sporów zarówno na sucho jak i na nietrzeźwo 😉

I tak na pierwszy ogień idzie plik z narzędzi GWT: kryteria dość proste: odstrzeliwujemy katalogi, precle, blog/strona zagraniczna (czytaj: niepolskojęzyczna). Do katalogów i precli wysyłamy mejle, ewentualnie kontaktujemy się przez panel z prośbą o usunięcie linków do serwisu. Jeśli link został usunięty – OK – oznaczamy w tabelce zieloną mordką. Jeśli brak odzewu oznaczamy na czerwono i niestety „leci” do pliku disavow.

Fora innojęzyczne (np: korea, japonia i inne) – tam linka praktycznie nie da się usunąć – ALE ! jeśli osoba, która linkowała Nam domenę posiada raporty w postaci np projektów Xrummera można to odkręcić poprzez uruchomienie projektu i usuniecie linka. Niestety to bardzo rzadko spotykana „przyjemność”.

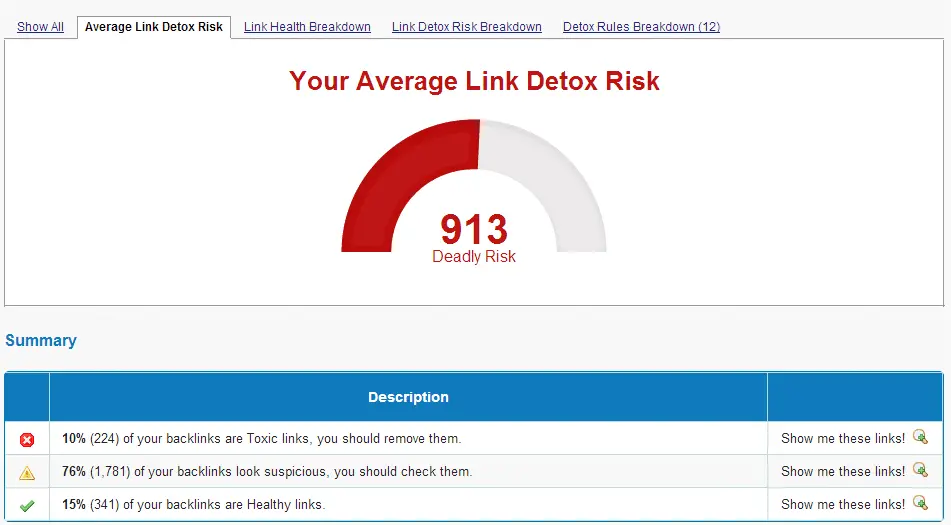

Można skorzystać z narzędzi ogólnodostępnych na rynku np LinkDetox czy LinkRisk – oba płatne, a ten drugi drogi 🙁 Tutaj należy zwrócić uwagę, że narzędzia są bardziej wspierajace niż dające konkretny rezultat – nie mniej jednak generalnie sprawdzają się – znam tylko LinkDetox więc o tym mogę powiedzieć, że jest dobry ale i tak analizuję to co on „wypluł”. W programie tym, można śmiało rzec, że cokolwiek z wynikiem powyżej 200-250 stanowi podstawę do „czyszczenia”. A tak wygląda zaspamowany serwis „jechany” publiczną bazą.

Przykład zaspamowanego precla z nienaturalnymi linkami:

Na co zwrócić uwagę w katalogu:

- jeśli przyjmuje dużo zaplecza (wiem wiem pojęcie względne) – zaznaczamy do odstrzelenia

- jeśli w treści wpisów są linki w treści – z reguły odstrzeliwujemy

- jeśli wszystkie katalogi (np danej grupy) bazują na jednej skórce – tez odstrzeliwujemy

- zwracamy uwagę na TITLE – czy jest zbieżne z nazwą domeny – dość często okazuje się, że domena nazywa się „ptak” a w TITLE jest „tygrys” – tak tak – kilka grup jak przerzuca bazę zapomina o tym i jest to łatwe do namierzenia – oczywiście odstrzeliwujemy

Linki site-wide:

- jeśli jest dużo (pojęcie względne ale np firmy tworzące sklepy mają tendencję do wklejania swojej marki w stopkę) – opatrujemy jako rel=”nofollow” ewentualnie usuwamy

- jeśli są w postaci banerowej – tez dodajemy nofollow

- jeśli są w postaci widgetu (pozdrawiamy Wrocław) – też dajemy nofollow

Zaraz mi napiszecie dlaczego duży może więcej bo są firmy, które w stopce mają zestawy linków do grupy swoich serwisów – ano mogą mieć. I tyle.

Poza tym pozostaje „szkiełko i oko”.

4. Tworzenie plików do disavow

Osobiście tworzę dwa pliki:

- google docs – excel – gdzie umieszczam domeny/linki usunięte – z czego oczywiście jesteśmy zadowoleni 🙂 Usuniętych linków/domen nie trzeba wysyłać w narzędziu do zrzekania się

- plik tekstowy – ewentualnie csv – gdzie umieszczam domeny/linki, których z jakichś przyczyn nie udało się usunąć

Plik tekstowy będzie przyrastał i w końcowym efekcie będzie gotowy do użycia w narzedziu „disavow tool”. Czyli będą to linki/domeny do zrzeczenia się.

W zależności od stopnia „zaspamowania” badanego serwisu tworze sobie trzeci plik (też excel w google docs) gdzie wrzucam nieusunięte domeny i linki opisując je, co z Nimi robiłem i dlaczego nie został link usunięty. Jest to przydatne w przypadkach, gdy piszemy któreś tam n-te rozpatrzenie bo nie udało się za pierwszym razem dostać „rozgrzeszenia” 😉

5. Wgrywanie plików i ponowne rozpatrzenie

Mając gotowy pliczek do DISAVOW wgrywamy go, otrzymujemy stosowny komunikat (jeśli plik był poprawnie wykonany to ukazuje się stosowna informacja). Z reguły odczekuję 2-3 dni i pisze zgłoszenie o ponowne rozpatrzenie. W formularzu podaję informację co zostało wykonane, co zostało zrobione, udostępniam plik trzeci z opisem czego nie udało się wykonać (plik należy udostępnić z odpowiednią opcją „dla każdego kto otrzyma link”. Piszę też ile linków zostało usuniętych, ile nie (taka mała statystyka), czy były używane SWLe i co z tym fantem zrobiono i tak dalej … Wskazane jest skopiować sobie to co pisaliśmy w formularzu do jakiegoś pliku tekstowego gdyż Google tego nie zapamiętuje i nie wysyła potwierdzenia.

Czekamy kilka dni i … albo jest dobrze albo wracamy do punktu nr 1.

6. Reasumując punkty 1 – 5.

- zbieramy wszelkie informacje związane z linkowaniem witryny celem przybliżenia nas do usunięcia filtra od Google

- analizujemy i podejmujemy decyzję

- wgrywamy pliki, piszemy rozpatrzenie i czekamy 🙂

7. Czy są inne metody na wyjście z ręcznego filtra ?

Zachodzi istotne podejrzenie, że jest możliwe wyjście z filtra za nienaturalne linkowanie. Moim zdaniem (podkreślam „moim”) zależy to od stopnia zaspamowania witryny. I tak weług różnego rodzaju hipotez, domniemań, guseł (dobrze to napisałem?!):

- zaprzestajemy zdobywać link ze stricte samym anchorem

- edytujemy wpisy w katalogach/preclach zmieniając/usuwajac anchory i np zastępując tytuł (anchor) brandem (np nazwa domeny, nazwa firmy, nazwa firmy + anchor)

- do linków wstawiamy rel=”nofollow”

- zaczynamy zdobywać linki z „zaufanych źródeł”

- nie robimy NIC !!! po prostu czekamy

- i tak dalej … 😉

Osobiście przećwiczyłem dwa rozwiązania w obu przypadkach miałem pozytywne efekty po ok 2-3 tygodniach – strony wróciły do TOPów i na razie tam siedzą (ćwiczenia przeprowadziłem na własnych stronach blogowych). Jednakże o tym zapewne w ciągu kilku miesięcy powstanie szereg wypracować oraz wątków do analizy więc tutaj rozpisywać się na ten temat nie będę.

Podsumowanie:

Powyższy temat jest wysoce kontrowersyjny i wzbudza bardzo gorące emocje. Jest niewątpliwe tematem świeżym, zwłaszcza w kontekście rozsyłanych powiadomień w maju (ca 25 dnia) oraz lipcu (od wczoraj) i z którym nie do końca wiadomo czy wszyscy idą właściwym tropem. Niniejszy wpis powstał na prośbę kilku klientów ale również dzięki kilku zapaleńcom z forum SEO (forum.optymalizacja.com). Tutaj chciałbym tez podziękować im bo bez ich analiz i pomysłów, niesamowitej krytyki, nie napisałbym tego com napisał – blake, zakrecony, Szlafrock i reszta entuzjastów 😛

Jeśli potrzebujesz pomocy przy odfiltrowaniu serwisu lub masz podejrzenie, że Twój serwis jest ofiarą „złych linków” skontaktuj się z Nami – chętnie pomogę !

Jeśli zauważyłeś spadek ruchu organicznego i podejrzewasz filtr lub karę ręczną zajrzyj > tutaj <.

No spoko. Zastanawiam się tylko, czy dla ludziów z małym budżetem w którym miejsca nie ma na zakup Link Detoxa jest jakaś nadzieja (oprócz ręcznego skanowania każdego linku?

Swoją drogą zastanawiam się co z serwisami które po pingwinach poleciały na ryj, a ostrzeżenia w GWT nie otrzymały?

Nie korzystam z Link Detoxa, a żyję 😉 Kwestia regularnego pilnowania własnego podwórka, szybkich reakcji w sytuacji nagłego przyrostu linków i sensownego pozyskiwania odnośników we własnym zakresie. Jedyny raz, kiedy miałam styczność z filtrem to ten, gdy przejęłam stronę po firmie SEŁO, która zaspamowała ją tysiącami śmieciowych odnośników. W ciągu kilku godzin od otrzymania komunikatu od Google, porządek był zrobiony, a raport z wyjaśnieniem sytuacji – wysłany (ze szczegółami w stylu kiedy rozpoczęte zostały prace dotyczące usuwania nienaturalnych odnośników, bo wzięłam się za to jeszcze przed otrzymaniem wiadomości). Odpukać, domena dzisiaj ma się nieźle.

Jest też tańszy odpowiednik Link Detoxa – Seo odkurzacz, Możemy też wspomagać się gwt, majesticem, ahrefsem, jeśli budżet pozwala na np miesiczny zakup.Trzeba też pamiętać, tak jak opisał, to Paweł – używajmy głowy. Narzędzia są tylko wspomagaczem, aby w pewnym stopniu usprawnić pracę.

Witam,

Pełna profeska, mam jedno pytanie czy na to powiadomienia co od wczoraj latają w ilościach milionowych tez jest taka sama procedura.

P.S – zdjęcia to masz na bank z „vizy” do USA.

pozdrawiam

DJ

Kuba, jak masz scrapebox-a + excel, to używając głowy możesz zrobić taką analizę bardzo sprawnie 😉

Z tego co kojarzę, brak powiadomienia w GWT nie wyklucza uderzenia pingwina.

A jeśli budżet nie wystarcza na SB i excela – no cóż, jaki budżet takie SEO 😉

W środę dostałem w GWT info o nienaturalnych linkach i ręcznie nałożonym czymś, od razu usunąłem linki ze statlinka (to pewnie jakieś 10-15% wszystkich linków, reszta katalogi, precle i fora), dodałem je do disavol tool i napisałem prośbę o rozpatrzenie. Co dziwne w czwartek strona skoczyła na najważniejszą dosyć trudną frazę z 8 miejsca na 3. Dzisiaj jest piątek i strona dalej na 3 miejscu. No i się zastanawiam czy to jakiś bug filtra czy jeszcze mi się ten filtr nie uaktywnił czy jak?:)

Pytanie jest jakieś treści było powiadomienie: czy było tam o SWLach czy tylko takie wstępne ostrzeżenie, żebyś coś jednak zadziałał…

SB i excel tylko w przypadku filtra za śmieciowe linki z automatów. W przypadku swli to raczej sprawdzanie po kolei przykładów takich linków w GWT – tam są podane domeny i przykłady podstron z linkiem.

A jak wygląda sprawa z zagranicznych blogów które mają PR 3 i więcej ? Usuwać czy zostawiać ?

Ma nofollow czy nie ? Jak ma nofollow bym zostawił aczkolwiek jeśli zdobywany automatem i nijak niepowiązany bym usunął – tak na wszelki wypadek 🙂

Pawle, komunikat brzmi dokładnie tak: „Wykryliśmy sztuczne lub nienaturalne linki prowadzące do Twojej witryny. Kupowanie linków i uczestnictwo w programach ich wymiany w celu manipulowania rankingiem PageRank stanowi naruszenie wskazówek Google dla webmasterów.

Z tego powodu Google podęło ręczne działania antyspamowe w odniesieniu do elementu [tutaj adres serwisu]. Google może podjąć kolejne działania w odniesieniu do Twojej witryny lub jej części. ”

Ni cholery nie wiem o co kaman 🙂 nie rozumiem jakie „działania antyspamowe podjeli” bo żadnych spadków nie odnotowałem, ba nawet wzrosty mam:)

Ja nazywam to żółtą kartką – tylko czasu po tym jest za mało 😉 Aczkolwiek zgodnie z sugestią kolegi „blake” można nic nie robić, można też zacząć linkować lepszymi linkami (jakościowo). Jednakże jeśli jechane tylko automatem i profil jest naprawdę zły – to nic nie pomoże i witryna lotem koszącym utraci pozycje.

Ja też dostałem taki komunikat. Nie wiem czy ludzie w google się nudzą i wymyślili takie masowe ostrzeżenie, żeby się plebs zbytnio nie panoszył. Jeśli u siebie miałbym to ostrzeżenie z czymś łączyć, to było to wystąpienie jednego z moich blogów na wykopie.

Nadal Kamilu masz wzrosty ? 🙂 Też zaobserwowałem w pierwszej fazie wzrost a następnie dokuczliwy upadek na jednej z „powiadomionych” witryn 🙂

„Donieśli” mi, że jestem muzą :D, więc trochę na temat napiszę.

Po kiego …. dalej opisujesz imbecylom jak zgłaszać linki? Oni nie zrobią tego dobrze, 90% wrzuci wszystko co tam ma w GWT do pliku i zgłosi całość, bo dla nich wszystko będzie podejrzane… Pousuwają nawet dobre linki. Co do przykładu „zaspamowanego” precla… to aż brak mi słów. Jeden post nie świadczy o tym, czy domena jest zaspamowana, czy jest wartościowa czy nie.

Miałem jakiś czas temu kompletnie zaspamowanego phpfoxa (taka społecznościówka dla tych co nie wiedzą), PR3, site kilkaset k i taki posta jak pokazałeś to bym delikatnie powiedział był na nim jako rodzynek. Ruski i chinole mnie dopadły – 50k userów, rekordzista miał 600 linków w jednym poście a wiem, że ta domena miała mega moc i ma do dzisiaj, chociaż stoi na niej już coś innego.

Wracając do tematu zgłaszania linków. Jak możesz zrób jeszcze jeden test – masz już pewnie pełno tych raportów, które tam wrzucałeś z tymi „złymi” linkami – przy kolejnej domenie, którą będziesz chciał ratować zrób tak:

1. Wrzuć w ten plik jakieś stare linki z innej domeny, nie analizuj w ogóle linków dla tej domeny którą będziesz zgłaszał.

2. Podlinkuj domenę, którą będziesz chciał zgłaszać „dobrymi” (cokolwiek to znaczy) linkami w odpowiedniej ilości.

3. Opisz, że czyściłeś, plik jest i jest cycuś glancuś.

4. Daj znać jaka będzie odpowiedź.

Również obawiam się takiego podejścia. Google jest tylko robotem i z pewnością wiele spam stron traktuje na równi z wartościowym contentem. Jeśli odetniemy sobie korzeń(nawet ten zbudowany przez spam) może się okazać, że spadniemy jeszcze bardziej. Ktoś już w półświadku zwrócił na to uwagę, ja przeprowadzam właśnie test w sumie nie mam więcej już do stracenia, za kilka tygodni pewnie będę znał werdykt Google.

Mam pytanie.

Jeśli mam filtr algorytmiczny za linki do kilku podstron, to przebudowa serwisu aby linki te prowadziły do 404 zaowocuje że filtr odpuści?

Nie wiem – nie testowałem takiego rozwiązania…

I to jest cenny komentarz 🙂 Tak, to działa dla pierwszego Pingwina. Nie wiem jeszcze czy dla najnowszego także.

Jednak same 404 nie wystarczą, trzeba porobić trochę więcej.

?Donieśli? mi, że jestem muzą :D, więc trochę na temat napiszę.

Po kiego ?. dalej opisujesz imbecylom jak zgłaszać linki? Oni nie zrobią tego dobrze, 90% wrzuci wszystko co tam ma w GWT do pliku i zgłosi całość, bo dla nich wszystko będzie podejrzane? Pousuwają nawet dobre linki.”

Kiedy blake dojdzie do Ciebie, ze największym imbecylem to jesteś ty ?

Nie wmawiaj na sile wszystkim wkoło swoich racji, bo nikt nie wierzy w te twoje wynaturzenia. Jeżeli masz coś do powiedzenia w tym temacie, to przestań wreszcie politykować i daj konkretne dowody na to, ze metody opisywane choćby na tym blogu są złe i nie powinny być stosowane. Jak na razie to klapiesz swoim otworem gębowym na prawo i lewo, ale nigdzie nie potrafisz napisać co tak naprawdę należy zrobić z zaspamowaną i ukarana domena. Krytykować potrafi każdy, bo to bardzo łatwe. Wielu stosuje metodę opisana tutaj i chwali sobie efekty. Jak na razie nigdzie nie podałeś lepszego sposobu wiec skończ wreszcie z ta krytyka bo jak już raz Ci napisałem na wymioty zbiera od tego.

Chciałbym zobaczyć listę linków, których się zrzekłeś.

Mam teorię, na co patrzyć przy karach algorytmicznych. (banalne)

Co do ręcznych kar, podejrzewam, że po zgłoszeniu sprawdzają pozostałe linki na wyrywki i akceptują lub nie.

raczej nie na wyrywki 🙂 na pewno nie 🙂

Jak zwykle – pełen PROFESJONALIZM. Świetna robota Paweł 🙂

@Paweł

Tym artykułem znowu wkładasz kij w PiOwisko 🙂

Ktoś musi 😉

Wrocław pozdrawia 😉

Niektóre narzędzia tworzyło się wcześniej niż almighty google webmasters guide.

Pawle ja jestem tolerancyjną osobą, chcesz używać tego spam raportu – ok, Twoja sprawa ale dlaczego tym artykułem namawiasz gówniarzy do naśladowania?

Mam trochę wrażenie, że próbujesz się sam przed sobą usprawiedliwić. W moich oczach straciłeś i to bardzo mocno.

Nie widzę potrzeby usprawiedliwiać się i swojego postępowania w czyichkolwiek oczach. Nie wiesz i nie widziałeś jak pracuję, jak powstają zalecenia i co z tego się robi – więc proszę nie oceniaj kogoś o kim nie masz pojęcia jak pracuje.

Ja też jestem tolerancyjny ale jak każda tolerancja istnieją jej pewne granice 😉

Dzięki za komplement.

Cóż dobry artykuł kuje w oczy. Zamiast pochwalić za rzetelne przygotowanie długiego i solidnego wpisu, autor wplątywany jest w utarczki słowne rodem z bazaru. Mam ponad 30 i jestem gówniarzem ?Wojtek z takim zapałem idź walczyć o krzyż i Tupolewa.

Ja nie mam pretensji do wojtka – jak widzisz zaakceptowałem komentarz bez jego akceptacji (twój też chociaż ostatnie zdanie mi się nie podoba). Każdy ma prawo kreować swoje osądy tak jak mu wygodnie.

Niestety ale bardzo dużo złego robisz dla społeczności SEO (w tym sobie) promowaniem D. Toola. To się zemści bardzo mocno wraz z upływem czasu. Google będzie oznaczał coraz więcej stron jako spamowe – skąd masz pewność że te które prowadzą do twoich stron nie dostaną flagi dzięki czytelnikom tego wpisu? Tylko nie mów że nie używasz podejrzanych linków, bo mam na oko parę Twoich stron i wiem co się tam dzieje.

Ludzie, nie bądźcie krótkowzroczni i nie psujcie rynku pomagając za free googlowi. Skuteczność DT jest do dziś nie udowodniona, a nawet jeśli jakoś działa to na moje oko Google w ten sposób może dawać jakiś tymczasowy bonus tylko po to żeby poszła fama, że to działa więc ludziska masowo zaczną za free im dawać linki do analizy. Nie idźcie tą drogą!

[ sarkazm mode on ] Dodałbym jeszcze coś: nie psujcie poprzez DT biznesu z zapleczami, spamem, SWLami, preclami – bo jak to zgłosicie to już nic nie zostanie. No i SEO nie będzie tanie tylko drogie i pozostanie jedynie Adwords – czyż nie mam racji ? Czyż w tle nie słychać szczęku łańcuchów i kłódek zamykających wiele firm SEO żyjących dotychczas z takich czy innych rzeczy ? NIe idźcie tą drogą ! [ sarkazm mode off ]

Nic nie jest udowodnione czy działa czy nie bo nikt nie odważy się na opublikowanie jakichkolwiek testów. Obecnie odzyskiwanie domen mozolnie ale zaczyna przynosić efekty dla klientów – czysta zdrowa domena – a klienta interesuje właśnie jej oczyszczenie i perspektywa powrotu na wysokie pozycje. Oczywiście nie ma gwarancji na to, że się wróci – ale dopóki jest narzędzie i furtka to wszyscy (no może większość) będzie z tego korzystała.

Z drugiej strony nikt nie udowodnił, że są inne metody na wyjście z filtra – bo ten kto je zna siedzi cicho i patrzy jak konkurencja się poci, wysila i … zamyka działalność.

Kompletnie nie rozumiem tej obawy przed Disavow Tool. Chyba nikt nie ma już wątpliwości, że to narzędzie, który służy Google do uczenia sieci neuronowej do wykrywania zaplecza/sztucznych linków… Pytanie tylko, no i co z tego?

Zmieniające się warunki, rosnąca konkurencja i stale podnoszona poprzeczka to właśnie to co w SEO jest najfajniejsze. I tak zawsze będziemy krok przed Google.

Najlepszą metodą na wyjście z filtra jest po prostu niedoprowadzanie do niego. Zauważ, że Google musiało uwzględnić w swojej polityce D. Toola, że ludziska przestaną się bać nawalać linkami bo zawsze można zrobić request – takie kody na nieśmiertelność. Dlatego nic nie ma za darmo i każda witryna zgłoszona do DT na pewno ma „kartotekę” – jak ją wykorzysta Google za np. pół roku, tego nie wie nikt. W ogóle paradoksalnie jak rozniesie się wieść (prawdziwa czy nie) że DT działa to spam na moneysite będzie jeszcze większy, właśnie z powyższej przyczyny.

Wszyscy używający D Toola jesteście darmowymi praktykantami najbogatszej korporacji świata. Mało kto zauważył, że wraz z wprowadzeniem DT Google zaostrzyło BARDZO politykę odnośnie tolerancji proxy, czyli toleranacji scrapowania (czytaj – zdobywania świeżych lokalizacji). Obecnie scrapowanie jest gigantycznym problemem. Przez to ilość potencjalnych nowych lokalizacji spadła, wszyscy zaczynamy kisić się w zbiorze paru miliionów linków które można użyć za free, a które pomału są oznaczane jako „spamowe” dzięki rycerzom na białych koniach. Wspólny tort maleje a wy jeszcze sypiecie go solą.

W ekonomii jest takie zjawisko znane jako „dylemat więźnia” – który ma oczywiste rozwiązanie, wszyscy więźniowie zyskują kiedy zupełnie nie współpracują z organami – kiedy jeden zacznie tracą wszyscy łącznie z nim samym (tak w skrócie).

„Najlepszą metodą na wyjście z filtra jest po prostu niedoprowadzanie do niego.” – i to jest kwintesencja całej dyskusji. A skoro się doprowadziło szuka się drogi na wyjście z niego.

” Ludzie, nie bądźcie krótkowzroczni i nie psujcie rynku pomagając za free googlowi. ”

Aby było jasne, na wstępie chce napisać, ze nie jestem żadnym białym rycerzem.

Napisz mi proszę o jakiej pomocy Google tutaj piszesz ?

Skoro Google wysyła powiadomienie o złych linkach, a konsekwencja powiadomienia jest nałożenie filtra. To przecież Google doskonale wie jakie linki prowadza do zafiltrowanej domeny.

Wskazanie w DT linków toksycznych niczego nie zmienia, bo o ich istnieniu Google i tak wie, skoro najpierw przysłało powiadomienie, a potem zafiltrowalo domenę.

Nie da się w tej sytuacji iść droga dylematu więźnia. W tej rozgrywce jest więcej zainteresowanych.

Co ma zrobić właściciel strony, skoro 7 lat temu, oddal stronę do pozycjonowania dobremu pozycjonerowi. Ten pozycjoner, za pieniądze szybciutko wypozycjonowal stronę w topy. Potem okazało się, ze inni tez chcą być w topach. Nastała era blastów, kto więcej ten wyżej. Nagle algorytm Google się zmieni i blasty sa bee. Pozycjoner mówi daj mi inna domenę bo ta jest spalona. A jak ja mam dać inna domenę skoro to jest marka mojej firmy od 10 lat ?

To nie jest sprawa moralna, tutaj chodzi o kasę. Wiele firm traci dochody i gadanie o tym czy zgłaszanie spamerskich linków jest etyczne mija się z celem.

I tutaj jest właśnie miejsce dla takich ludzi, jak właściciel tego bloga. Ktoś musi zrobić porządek i nie ma na to wyjścia. Gadanie o utracie dobrych miejscówek jest chybione. Jak by to były dobre miejscówki, Google by się tego nie czepiało.

Co do uświadamiania publicznego tutaj na blogu, to tez jestem za tym. Lepiej co by zwykły użytkownik wiedział jak się zabrać za usuwanie linków niż miałby faktycznie pousuwać wszystkie.

„Skoro Google wysyła powiadomienie o złych linkach, a konsekwencja powiadomienia jest nałożenie filtra. To przecież Google doskonale wie jakie linki prowadza do zafiltrowanej domeny.”

Skąd wiesz, że wie? A może powiadomienie wysyłane jest na podstawie nienaturalnej zmiany pozycji w dłuższym okresie czasu, a powiadomienie jest blefem ze strony Google?

„Nie da się w tej sytuacji iść droga dylematu więźnia. W tej rozgrywce jest więcej zainteresowanych.” – To nic nie znaczy, masz X więźniów zamiast dwóch…. ale idąc dalej zgadzam się z „To nie jest sprawa moralna, tutaj chodzi o kasę. Wiele firm traci dochody i gadanie o tym czy zgłaszanie spamerskich linków jest etyczne mija się z celem.”.

Uważam, że trzeba założyć, że wszyscy „sypią” i tyle.

Coraz gorzej dzieje się w świecie seo. Skoro dodając swoją stronę do topowych polskich katalogów dostałem komunikat o nie naturalnym linkowaniu to ja już nie wiem jak można się samemu trochę „wspomóc”

Jak zwykle świetna robota 🙂 miło że są ludzie co mają pojęcie o czym piszą :>

Moim zdaniem google zaczyna brnąć w ślepą uliczkę. Działanie algorytmu powoduje, że są branże gdzie 80% stron jest depozycjonowane, bo analizując top10 widzę że 8 stron ma skoki przyrostu linków i kasowania. Śmiem wątpić że to działania w imieniu właścicieli, znalazłem tam gotlinka więc chyba tylko samobójca „jedzie” swl-em po stronie firmowej. To samo mnie spotkało, też oberwałem swl-em od „przyjaciół”.

Miałem stronę w top3 przez pięć lat, a teraz od półtora miesiąca pozycje 50-60 (ostatnio delikatnie do góry) i komunikat o nienaturalnych linkach przychodzących.

Skoro tak, to może pozycjonowanie w/g google od dziś ma polegać na tym, że zostawiam swoją stronę na pozycji 60, a napierd…. pierwsze 59 swl-ami. Po 2 tygodniach będę pierwszy 😉

Nie znam motywów google, ale ostatnie działania doprowadzą do tego, że zamiast dbać o swoja stronę, wszyscy będziemy się wzajemnie napier…. swl-ami i innym najgorszym śmieciem. Widać, że strony stają się coraz mniej odporne na szkodliwe działania konkurencji.

Być może chodzi o to żeby zniszczyć SEO i na placu boju pozostały tylko AdWords-y.

Czekałem na taki artykuł od bardzo dawna, dziękuje, z pewnością się przyda w walce o odzyskanie pozycji. Pozdrawiam!

Ja też się cieszę Sylar, że zechciałeś zajrzeć na bloga o pozycjonowaniu i zostawić nienaturalny link do swojej strony w komentarzu 😉

Dodajmy jeszcze do tego, że tak naprawdę nigdy nie wiadomo czy filtr odpuści po miesiącu czy po roku 😉

Owszem – nie wiadomo.

Krótkie pytanko – czy pozbywasz się również linków w preclach kulfika, które jakby nie patrzeć do najtańszych nie należą (a kojarzę, że też o nich wcześniej pisałeś i testowałeś)? A jeśli tak, to rozumiem, że bezpośredni kontakt ze zleceniobiorcą, a nie wysyłka do disavow, żeby nie upubliczniać? Choć pewnie i tak już te katy w formularzach do Google się przewinęły..

Tak usuwam – często na wszelki wypadek. Jeśli wpisy są usunięte to wielokrotnie wspominałem, że takich linków/domen nie trzeba zgłaszać do disavow. Wystarczy to opisać i statystycznie powiedzieć, że usunięto np 555 wpisów z precli.

Można pozycjonować blogami, forami, dobrymi katalogami i własnym zapleczem. Więcej to czasu zajmuje ale nie ma informacji o nienaturalnym linkowaniu. Na frazy trudne można wygenerować duży ruch dzięki dobrej optymalizacji i contentowi (ciężko to rozliczyć ale na własny użytek ruch będzie przepiękny). Mam klienta fryzjera, który prowadzi blog. 10% ruchu ma ze słów kluczowych 90% z blogu. Zapisy ma na parę tygodni do przodu. W każdej branży jest nisza, którą można łatwo zagospodarować. Później można wchodzić na trudniejsze frazy. Algorytm zawsze będzie opierać się o jakieś czynnik (zresztą całe życie to algo) więc nie ma co się martwić o SEO. Zawsze będzie pozycjonowanie jak nie linkami to czymś innym:)

Filip pisze: „Mam klienta fryzjera, który prowadzi blog. 10% ruchu ma ze słów kluczowych 90% z blogu” – i tu pełna zgoda, jeśli klient działa w „seksownej” branży o której dużo ludzi chce czytać.

W części zgadzam się z Kapitanem. Google wykorzystuje to do tworzenia listy stron które „przyjmują” linki seo.

Mechanizm jest prosty, mam 1000 linków, dostaję powiadomienia o nienaturalnych linkach więc zwykle wiem co może być nie tak, usuwam i zgłaszam. Dostaję następny komunikat i tu nie jest już tak łatwo bo nie bardzo wiadomo o które linki chodzi. Na wszelki wypadek znów zgłaszam kilkadziesiąt linków i robię Google prezent. Kolejnych ileś tam stron do oflagowania.

Tym sposobem za kilka miesięcy polecą wszystkie swl-e, prywatne bazy precli, itp…

Zostanie tylko zaplecze budowane na własny/klienta użytek ale to będzie drastycznie podnosiło cenę. W końcu cenowo seo zbliży się do adwords-ów.

I o to chyba w tym chodzi 😉

Czy linki ze średniej jakości katalogów przykładowo http://www.pl.boostdirectory.net, http://www.prweb.pl, http://www.mobutu.eu zgłaszacie czy nie ?

A drugie pytanie czy zgłaszacie zakładane ręcznie profile na stronach z wysokim TR gdzie nie linkujemy anchorem, a samym adresem ?

Ale co to jest „wysoki TR” ? To że według OSE, Majestica czy Ahrefsa TR jest wysoki to nic nie znaczy. TR nie istnieje w Google – pojawiło się jako chęć podkreślenia, że według jakichś tam serwisów scoringowych dana strona ma duży TR.

Katalogi musisz sam sobie oceniać, choć pojawiają się obfite głosy, że nie miejsce ale sposób dodania jest ważny. Oczywiście po odfiltrowaniu pewnych specyficznych rzeczy 😉

3 moje strony dostały filtry ręczne, od wszystkich 3ch już dawno odciąłem wszystkie swl`e, dodałem praktycznie wszystko do disavow co zostało z miejsc, w których nie udało się usunąć linków i nie było kontaktu z adminami.

Dodałem do wp, onet, na fora nofollow itp. i Nadal nic.

Jedna ze stron ciągle jest w adwordsach.

Z GWT ściągam linki i praktycznie na żadnej z tamtych stron nie ma odnośników do mnie.

A te co są to jakieś śmieci z swl do których nikt się nie przyznaje ale mam w disavow.

Ręce mi już opadają. Google po prostu nie chce tego odfiltrować.

Wiem, mam to na dwóch domenach – podobno trzeba do oporu. Nie mniej jednak zamiast linków sugeruje spróbować przeanalizować tylko domeny z GWT.

Czy są jakieś przeciwskazania do do ilości i częstości zgłaszania disavow i pon. rozpatrzenia dla jednej strony?

Tzn czy google się po jakims czasie uodparnia na zgloszenia?

Nie ma… możesz zgłaszać plik codziennie. Tylko musisz pamiętać, że za każdym razem będzie go czytał jakby od początku więc czy jest sens „męczyć maszynkę” ?

Mnie ciekawi jeszcze jedna rzecz – duża ilość linów z powtarzającym się anchorem. Powiedzmy, że wywaliłem wszystkie linki, o których mówisz o i doszło do sytuacji, że teraz 80% moich linków zawiera ten sam anchor. Widzę dwa rozwiązania – zdobywać nowe linki o wiele bardziej zróżnicowane, bądź też na jakiś czas usunąć część linków z anchorem żeby zmniejszyć dysproporcje. Jak się na to zapatrujesz?

Zacząłbym od zmniejszenia liczby linków z money keywords a jednocześnie zaczął budować nowe linki z brandem.

Świetny, rzeczowy post – gratulacje 🙂

Uważam, że krytykowanie za Disavow Tool jest bezpodstawne. Zgadzam się to narzędzie służy do „wystawiania” zaplecza G, ale nic na to nie poradzimy. Jestem przekonany, że większość osób zajmujących się SEO najpierw pomyśli o sobie i o swojej stronie, a dopiero później o ewentualnym skutku dla całej społeczności. Po prostu, ludzie z reguły najpierw myślą o sobie.

Czy to źle, że ludzie myślą przede wszystkim o sobie? Nie wiem.

Czy to źle, że w rezultacie działania Disavow Tool mnóstwo stron zapleczowych zostanie usuniętych? Uważam, że nie – to tylko podniesie poprzeczkę i tym samym będzie impulsem do rozwijania SEO. Konkruencja, ciągle zmieniające się warunki i koniecznosć bezustannego doskonalenia – przecież dlatego pasjonujemy się tą branża, prawda? 🙂 Przecież my (pasjonaci SEO) zawsze jesteśmy o krok przed G.

Niestety SEO zmienia się z dnia na dzień, a Gugiel nadal przykręca śrubkę w imię „walki ze spamem”. Także… do boju biali rycerze!

Oj tam oj tam 😉

Dziękuję za poradnik. Tydzień temu dostałem coś takiego od googla. Jestem blogerem, nigdzie nie kupowałem linków :/ Zgłosiłem na liście w pliku .txt trochę bezsensownych linków i załadowałem. Dałem „wykonano”. Ale żadnego potwierdzenia od witryny „Dzięki, przyjęliśmy”.

Rozumiem, że takiego potwierdzenia nie ma, czy tak?

Nie ma… po dodaniu disavow należy wysłać prośbę do G o rozpatrzenie.

Wiadomo, że nie ma konkretnych terminów ale tak z Twojego/Waszego doświadczenia „rozpatrzenie” ile może potrwać?

Tydzień/dwa do pół roku – tyle trwało/trwa odzyskiwanie domen po filtrze.

A co, jeśli filtr algorytmiczny jest za linki z rotacyjnego systemu wymiany linków i nie ma możliwości zablokowania domeny przed takim linkowaniem. Czy taką domenę można odzyskać?

Nie wiem czy wiecie, ale weblink już nie umożliwia zablokowania domeny i zezwalają na depozycjonowanie.

Wiemy że weblink już nie blokuje serwisu. Zacznij zdobywać lepsze linki niż tylko z eweba.

Swoją drogą to Google zaczyna przesadzać ze swoja polityką. wkrótce wszystko będzie złe, będzie trzeba za nich moderować szukajkę i jeszcze będziemy im wpłacać kasę za pozycje „naturalne”. To nie prowadzi do niczego dobrego.

Jak najwięcej linków ze stron zaufanych w Google i można w miarę spać spokojnie. Artykuł genialny i zapisany w folderze „filtry” choć mam nadzieje, że nie będę musiał go szybko otwierać. Pozdrawiam

„…po dodaniu disavow należy wysłać prośbę do G o rozpatrzenie.”

Czy wysłanie takiej prośby jest konieczne, nie wystarczy samo dodanie pliku disavow?

Jaka jest dokładna ścieżka do formularza, za pomocą którego mogę wysłać taką prośbę? Szukam, szukam po narzędziach google dla webmasterów i nie mogę znaleźć a nigdy tego nie robiłem.

Tak jest konieczne. Wysłanie RR masz „pod ręką” w panelu GWT gdzie jest zakładka „Działania ręczne” – wystarczy to rozwinąć i tam opisać sprawę.

Jeżeli strona złapała bana za spamowe linki i zgłosi się wszystkie linki do usunięcia i zacznie pracę, że tak powiem od 0. Czy ta taktyka ma sens?

Strona nie dostaje bana za linki tylko filtra… sens jest zawsze pytanie czy chcesz czekać kilka miesięcy na budowanie pozycji ? Wcześniej jednak trzeba tego filtra zdjąć a to nie będzie do razu …

Najgorsze jest to, że ludzie przyzwyczaili się do „szybkiego pozycjonowania”, przychodzą i żądają od razu efektu, narzekając, że „poprzednia firma wzięła kasę i jest jeszcze gorzej”, a jak zaczynam gadać o filtrach, GWT i D.tool, traktują mnie jakbym się urwał z kosmosu…

Nie ukrywam, że zdarzyła mi się taka sytuacja. Akurat nie stać mnie było na skorzystanie z Link Detox’a, ale poradziłam sobie. Tak na prawdę wystarczy dobrze zaplanować swoje działania. Teraz już wiem jak to robić. Mam nadzieje, że tym razem Google nie wywinie mi żadnego numeru 😛

Cieszy Mnie to niezmiernie że sobie poradziłaś (a może poradziłeś) ale linka do byle precla Ci wyciąłem 🙂

Witam,

Dziękujemy za obszerny poradnik wychodzenia z filtra. Bardzo pomocny, choć niektóre narzędzia, jak linkowy detox są zbyt drogie dla pojedynczych witryn. opłaca się tylko agencjom marketingowym.

Jeśli chcesz przeanalizować za darmo swoje linki to zarejestruj się na majesticseo.com , zweryfikuj swój serwis i … masz większy dostęp bezpłatnie 🙂

Paweł jak za pierwszym razem Ci się nie uda to robisz drugi plik disavow2 .txt z kolejnymi linkami czy poszerzasz stary o kolejne śmieci? W disavow tool można wgrać tylko jeden plik (stary się nadpisuje) i jak myślisz Google oczekuje że plik będzie aktualizowany czy można przyjąć, że jak raz wgrałeś to tych samych linków już nie trzeba wgrywać? W sumie nie widzę, by gdzieś było to opisane.

Powiększam stary plik disavow dopisując nowe rzeczy. Jeśli plik pokrywa się w 100% to nie ma sensu wgrywać go ponownie.

Moim zdaniem problem jest o wiele bardziej złożony. Zrzekanie się linków jest chore. Administratorzy stron sami powinni akceptować, które linki są dobre i prowadzą do ich stron. Zniknął by wtedy problem depozycjonowania i nieuczciwej konkurencji… Techniki Black Hat SEO przestały by istnieć, a problem spamu został ograniczony do minimum. Google jest na rękę całe zamieszanie wokół filtrów i banów, jak strona wylatuje z TOP’ów to jedynym ratunkiem na uzyskanie ruchu z wyszukiwarki są AdWordsy…

Dzięki za poradę jak wyjść z filtra

Mam pytanie odnośnie linków site-wide. Mam taki link na blogu na stronie nie na żadnej darmowej platformie. zastanawiam się czy usunąć ten link czy pozostawić go bez anchora.

Dodać NOFOLLOW najbezpieczniej 🙂 Natomiast jeśli chcesz eksperymentować to dać adres URL jako anchor.

ok za jakiś czas dam znać co z tego wyszło 🙂

Cześć Paweł,

będziesz jeszcze pisał czy już całkowicie przechodzisz w analitykę?

Wkrótce pojawi się jakiś wpisik drobny .. ale drobny 🙂 W tej chwili brak mi tematów do pisania.

Może „pozycjonowanie po pingwinie 2.0 na przykładach”, albo „co działa po ostatnim update google” lub „analiza przykładów nienaturalnych linków z powiadomień Google”

Problem polega na tym, że niewiele rzeczy działa, które można uznać za bezpieczene – to już nie to samo SEO co przed majem 2013. Teraz jest trudniej. Widzę to szczególnie po liczbie zgłoszeń o ratunek z filtra – zgłaszają sie duzi i mali, klienci których agencje wpędziły w filtry jak i same agencje proszą o pomoc … Napierdalanka linkami się skończyła – teraz czas na SEO3.0 – czyli content i rozsądne małe linkowanie…

Metodą, którą opisywał jakiś czas temu Mkane? Chciałbym to zobaczyć w praktyce, bo nie do końca dowierzam.

Analizowałem dzisiaj serpy dla kilku branż i top1 często jest utrzymywany za pomocą swl, lub domeny praktycznie bez linków.

Nie, nie maskowane, bo znam ich historię od lat i zawsze mieli tylko wpis z panoramy i z 20 innych linków.

W innych przykładach strony pokazują się na całkiem inne frazy niż do nich prowadzą. (optymalizacja? nie sądzę)

Kolejny ma top za stopki na 5 forach.

Ja jestem w trakcie testów linkowania na dużą liczbę fraz podobnych do głównej, fraz brandowych, piramid itd. Ale wydaje mi się, że Google jeszcze coś zmieniło, myślę, że liczą linki dopiero z jakimś dłuższym stażem, albo tylko z tych stron, które mają ich odpowiednik Trust na odpowiednim poziomie.

Ps. Nofollow też nie robią różnicy.

Ps do PS: wiem 😉

witam mam kilka pytań

wygenerowałem sobie raporty z majesticseo i ahrefs jakim programem połączyć te wszystkie linki, sprawdzić PR domen itp. Raport końcowy w exelu. Istnieje jakiś program który to zrobi ?

Spróbuj może sitecondition.com – polski wytwór może ułatwi CI życie.

mam jeszcze jedno pytanie

w disavow zgłaszać strony które nie działają oraz strony zbanowane??

Te które nie działają nie potrzeba jednakże czasem myślę, ze warto bo nei wiadomo jaki spam sie na nich pojawi.

Witam miło – pierwszy mój wpisik.

Pozwolę sobie odświeżyć nieco temat. Naczytałem się już sporo o filtrach, dobrych i złych linkach i o analizach linkowania. Nigdzie jednak nie znalazłem opisanej sytuacji w której strona ma powiedzmy 1000 backlinków, z czego większość okazuje się złej jakości i nadaje się tylko do wycięcia. Na tę chwilę nie ma na witrynie ręcznego filtra. Uprzedzając zatem jego nałożenie najbezpieczniej jest linki jak najszybciej wyciąć. Czy wycięcie w krótkim czasie powiedzmy 60% linków nie spowoduje załamania uzyskanych pozycji na ważnych dla witryny pozycji? Kiedyś takie działanie było tragiczne w skutkach…

Oczywiście, że poleci skoro odcinasz linki to odcinasz moc ich (jaka by nie była)….

No to co lepsze? Zrobić porządek z linkami i zlecieć w dół, czy poczekać aż dostanie się filtr i też polecieć w dół? 🙂

Ja bym zrobił porządek ale cały czas zdobywał wartościowe odnośniki.

Dzięki za podpowiedź. Spróbuję…

Takiego artykułu szukałem, dziękuję że do napisałeś. Dostałem ręczny filtr i właśnie robię selekcję linków co z linkami spamowymi gdzie np na jednej domenie miałem ich 19000 prowadzących do mojej strony a domena wygasła i nie jest przedłużona przy wejściu w link info nie odnaleziono serwera czy takie linki zliczam i zaznaczam jako usunięte w dokumencie google docs ? excel ?

Czy linki z domen wygasłych i linki prowadzące do domeny z przekierowaniem 301 na domenę pozycjonowaną po usunięciu 301 zgłaszam jako usunięte ?

Domen usuniętych nie musisz zgłaszac bo link już nie istnieje. jesli chodzi o serwisy z 301 to lepiej usunąć 301 jesli się da – stron która jest przekierowywana może miec nałożona karę, która to przenosi się jak zaraza.

Witam mam pytanie jeśli w końcu udało mi się ściągnąć filtr ręczny to jak ściągnąć filtr EMD, lub algo? Sam program Seoodkurzaczs starczy ? Bo po ściągnięciu linków i przyłożeniu nowych pozycja nie chce drgnąć lawiruje koło 100-120 pozycji.

Filtr EMD czy ALGO dowiesz się o ściągnięciu wtedy kiedy np wzrośnie Ci ruch, pozycje etc… to są filtry takie rekalkulacyjne czyli G przelicza pozycje dla twojego serwisu.

Jeśli po przyłożeniu nowych linkow nic nie rośnie to:

– linki są do kitu

– nadal stosujesz te same techniki za co dostałeś karę

– strona nie jest lub słabo jest zoptymalizowana

i szukamy dalej …

Strona została poszkodowana właściwie na 2 bardzo ważne frazy, na inne strona idzie w top 10 i top20 bez problemu, tak jakby by był nałożony filtr na 2 frazy

Objaw prawidłowy – kara obejmuje to co zostało źle wykonane. Jak się nei dotykasz do długiego ogona to on akurat będzie dobrze rankował.

To nie jest sprawa moralna, tutaj chodzi o kasę. Wiele firm traci dochody i gadanie o tym czy zgłaszanie spamerskich linków jest etyczne mija się z celem.

W biznesie nie ma etyki. Jest biznes.

Niestety disawov to półśrodek to pułapka którą sami tworzymy na siebie tracąc kolejne miejscówki…

Bzdura – gdybyś nie spamował(a) tak jak umieszczasz linki w wypowiedziaxch na blogu nie trzbea byłoby uzywać DT 😛